はじめに

交通系Youtuberとしておなじみ西園寺さんの動画、「【過酷】大阪駅から1日中”路線バス”だけ乗り継いだら東西どっちが遠くまで行ける⁉︎」のうち、ZAKIさんがすすんだ東行きのルートを検証するものです。

なおすでに「えらい会長のローカル路線バスチャンネル 」さんが検証されているのでそちらを先に御覧ください。

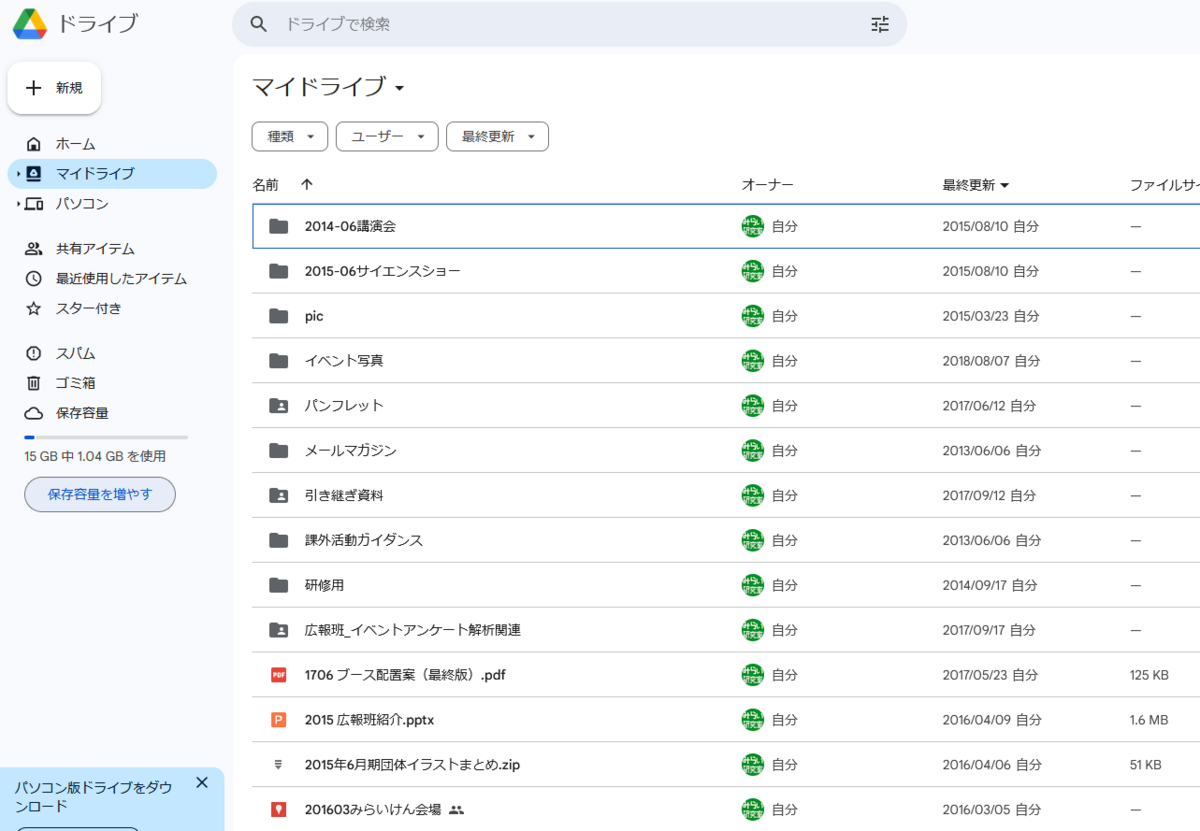

ZAKIさんの実際のルート

- 大阪駅前 (10:11) → 江口橋 (10:57): 大阪シティバス:37

- 江口橋 (10:57) → 桂本団地 (12:03): 徒歩2.1km

- 桂本団地 (12:08) → 高槻駅南 (12:48): 高槻市営バス:[22/1]

- 高槻駅南 (13:10) → 阪急上牧駅 (13:33): 高槻市営バス:[7/1]

- 阪急上牧駅 (13:33) → JR山崎 (14:13): 徒歩3.2km

- JR山崎 (14:13) → 長岡京 (14:42): 阪急バス80系統

- 長岡京駅東口 (15:35) → 竹田駅西口 (16:15): 京都市交通局:南2

- 竹田駅東口 (16:31) → 京都駅前 (16:50): 京都市交通局81

- 京都駅前 (16:54) → 三条京阪前 (17:20): 京都バス:17

- 三条京阪前 (17:48) → 山科駅 (18:08): 京阪バス:22A

- 山科駅 (18:15) → 緑が丘 (18:19): 京阪バス:48

- 緑が丘 (18:19) → 大津駅 (19:18): 徒歩4km

- 大津駅 (19:40) → 唐崎 (19:57): 江若交通バス:102

大阪京都間は淀川西岸を経由して京都に至り、京都からは比叡山を経由する予定でしたが、京阪三条前での乗り継ぎに失敗し、山科へ転進、山科から徒歩で峠越えして大津に向かい、堅田駅を目指すも途中の唐崎で打ち止めとなりました。

最終的な直線距離は52kmとなり、西園寺さんの40.3kmを上回り勝利しました。

「えらい会長のローカル路線バスチャンネル 」さんの検証では比叡山経由に成功した場合、大津で実際と同じバスに収束するようでしたので、ミスを徒歩でカバーしたファインプレーだったと言えるでしょう。

しかし、もっと良い乗り継ぎはなかったのでしょうか?

大原まで乗り続けた場合

「えらい会長のローカル路線バスチャンネル 」さんの検証では京都駅から乗ったバスを三条京阪前で降りずに終点の大原まで行ったらどうなるかを検証していました。バス旅に多少でも詳しい方なら、鯖街道を目指すのは自然な考え方です。

- 京都駅前 (16:54) → 大原 (18:02): 京都バス:17

- 大原 (18:12) → 小出石 (18:20)

小出石の時点で大阪駅から直線距離で58.2km、残り40分を徒歩ででさらに北を目指すと60kmを超えることができたでしょう。

鯖街道について

なお鯖街道の小出石~途中~梅の木~細川~朽木を抜けるバスは土日の朝に1往復しかありません。堅田~途中~梅の木~細川を抜けるバスも同様です。

ロケ日は平日でしたので鯖街道を目指す場合は梅の木~細川~朽木を抜ける高島市コミュニティバスを利用するしかありません。梅の木からの最終バスこそ18:48と遅めですが、小出石から梅の木までは17kmもある山道で、大型車も通る交通量の多い道で危険であり、歩くのは現実的ではありません。

竹田駅で直接山科を目指したら

竹田駅で1分乗り継ぎを逃した時点で、三条京阪前の0分乗り継ぎ失敗は予想できていたことが動画中にもありました。ではこの時点で思い切って山科を目指したらどうなるでしょうか?

- 東山五条から山科に抜ける国道1号線

- 今熊野から山越えして大石神社に抜ける府道118号線

- 鳥羽街道駅から大石神社に抜ける稲荷山トンネル

- 京阪藤森駅から名神高速道路沿いに勧修寺に抜ける府道35号線

- 中書島から六地蔵に抜ける府道6号線

の5つがあり、この内2の山道はバスはありません。

竹田駅から山科を目指すのに最も北に位置する国道1号線を経由するのは遠回りです。山科~六地蔵間の主要なバスの拠点といえば醍醐バスターミナルです。こちらを目指すとどうなるか探してみると次のようなルートが見つかります。

竹田駅から醍醐バスターミナル方向に直行するバスを小野駅で降りて、山科に向かうバスに乗り継ぐルートです。小野駅~醍醐バスターミナルはルート的に同じになるのは地図を見れば確認できたと思われます。

別解として、小野駅の更に少し手前、勧修寺泉玉町で乗り換えるルートもありますが山科駅で収束します。

いずれにせよ実際ルートより1時間早く山科につくことができます。

山科から先の乗り継ぎを実際ルートに沿っていくと次のようになります。

- 山科駅 (17:15) → 緑が丘 (17:19): 京阪バス:48

- 緑が丘 (17:19) → 大津駅 (18:19): 徒歩(実際同様1時間かかったとする)

- 大津駅 (18:50) → 堅田駅 (19:33): 江若交通バス:102

- 堅田駅 (19:45) → 琵琶湖大橋東詰 (19:55): 江若交通バス:琵琶湖大橋線86(守山駅行き)

琵琶湖大橋東詰からはピエリ守山のほうに少し歩いて終了、直線距離は62kmとなります。時刻表上は守山駅行きを速野小学校前まで進めそうですが、大阪駅からの直線距離的には損してしまいます。

堅田駅の時点で60kmなので、守山駅よりはそのまま北に逢える真野駅方向に進みたいですが、バスは16時台で終わっており、歩いてもぎりぎり守山駅にたどり着かずに同じく62kmとなると思われます。

なお大津駅から東に向かうバスはちょうどいいものが見当たりませんでした。

淀川東岸で京都方向を目指したら

寝屋川市駅まで

実際ルートでは茨木市付近や天王山超えでバスが繋がらず徒歩を強いられていました。では淀川東岸を進んだらどうなるでしょうか?

- 大阪駅前 (10:06) → 守口車庫前 (10:33): 大阪シティバス:34

- 守口車庫前 (10:33) → 京阪守口市駅 (10:48): 徒歩1.1km

- 京阪守口市駅 (10:48) → 摂南大学 (11:35): 京阪バス:寝屋川守口線9

- 摂南大学 (11:45) → 寝屋川市駅 (11:57): 京阪バス:太間公園点野線11

守口車庫前から京阪守口市駅の乗り継ぎが非常にタイトで、実際ルートと同じ大阪駅前10:11発ではおそらく間に合いません。これを逃すと大日駅まで3kmを歩くことになったでしょう。

- 大阪駅前 (10:11) → 守口車庫前 (10:38): 大阪シティバス:34

- 守口車庫前 (10:38) → 大日駅 (11:17): 徒歩2.8km

- 大日駅 (11:21) → 寝屋川市駅 (11:47): 京阪バス:寝屋川守口線6

大日駅からのバスは豊富ですが、このあとの乗り継ぎを考えるといずれにせよ大阪駅は速やかに出る必要がありそうです。

京阪中書島まで

その先を見てみます。淀川東岸で京都方向に行こうと思ったらイオンモール久御山を経由したいところです。なぜなら他に木津川を渡るルートが石清水八幡宮から淀を歩いて渡るしかないからです。

- 寝屋川市駅 (12:02) → 京阪香里園 (12:30): 京阪バス:寝屋川北部線22

- 京阪香里園 (12:42) → 枚方市駅南口 (13:08): 京阪バス:香里団地線1

- 枚方市駅北口 (13:21) → 樟葉駅 (13:55): 京阪バス:出屋敷線39

- 樟葉駅 (14:10) → 松井山手駅 (14:41): 京阪バス:山手線67D

- 松井山手駅 (16:01) → まちの駅イオンモール久御山 (16:34): 京都京阪バス:イオン松井山手線17

- まちの駅イオンモール久御山 (16:48) → 京阪中書島 (17:04): 京都京阪バス:大久保中書島線25

ところが枚方市から順当に樟葉駅を経由してしまうと松井山手駅で1時間20分の待ちが発生してしまいます。結果として京阪中書島着が17時を過ぎてしまいますので、「竹田駅で直接山科を目指した場合」に劣ってしまいます。

イオンモール久御山へもう一本はやい乗り継ぎを探すと、長尾駅から歩くルートが浮上します。

- 枚方市駅北口 (13:26) → 長尾駅 (13:56): 京阪バス:出屋敷線20

- 長尾駅 (13:56) → 高速京田辺前 (14:26): 徒歩2.1km

- 高速京田辺前 (14:32) → まちの駅イオンモール久御山 (15:04): 京都京阪バス:イオン松井山手線17

- まちの駅イオンモール久御山 (15:08) → 京阪中書島 (15:24): 京都京阪バス:大久保中書島線25

長尾駅からの徒歩時間に余裕を持たせたい場合は、京阪香里園の時点で3分乗り継ぎを成功させる必要があります。

- 京阪香里園 (12:33) → 枚方市駅南口 (13:01): 京阪バス:津田香里線9A

- 枚方市駅北口 (13:09) → 長尾駅 (13:43): 京阪バス:出屋敷線25

- 長尾駅 (13:43) → 高速京田辺前 (14:13): 徒歩2.1km

- 高速京田辺前 (14:32) → まちの駅イオンモール久御山 (15:04): 京都京阪バス:イオン松井山手線17

- まちの駅イオンモール久御山 (15:08) → 京阪中書島 (15:24): 京都京阪バス:大久保中書島線25

山科まで

- 京阪中書島 (16:18) → 醍醐バスターミナル (16:42): 京阪バス:醍醐中書島線6

- 醍醐バスターミナル (16:43) → 小野駅 (16:47): 京阪バス:四条山科醍醐線88B

- 小野駅 (16:51) → 山科駅(17:06): 京阪バス:22A

京阪中書島から醍醐バスターミナルに直接向かうと非常に乗り継ぎがよくありません。醍醐バスターミナルでの1分乗り継ぎは机上の空論でしょう。しかも最終的に「竹田駅で直接山科を目指した場合」に収束します。

一旦竹田駅方向に向かうルートではどうでしょうか?

- まちの駅イオンモール久御山 (15:08) → 中書島 (15:23): 京都京阪バス:大久保中書島線25

- 中書島 (15:40) → 竹田駅西口 (15:56): 京都市交通局:南3

- 竹田駅東口 (16:24) → 小野駅 (16:45): 京阪バス:2

- 小野駅 (16:51) → 山科駅(17:06): 京阪バス:22A

「竹田駅で直接山科を目指した場合」に収束します。

結論

京都盆地を目指すにあたって、淀川西岸と東岸では最善手を選んだ場合竹田駅で収束するという結果になりました。

竹田駅までの歩き距離は

- 実際ルート: 5.3km

- 淀川東岸ルート: 3.1km

のように淀川東岸ルートが優れています。

一方で淀川東岸ルートでは多くのトラップがありました。

ZAKIさんはイオンモール久御山周辺のバス事情はある程度知っていたはずなので、そこから時刻を逆算すればこの乗り継ぎの可能性もありました。しかし、順方向に乗り継いでいけた実際ルートのほうがルート捜索は容易だったでしょう。

竹田駅から先については、バスの本数的に比叡山超えにかけるよりは山科を直接目指すほうが良さそうです。あるいは大原から北に向かうことも考えられますが、ロケ後に帰るのが困難そうなので堅田駅→守山駅に向かうほうが都合が良かったかもしれません。